J’ai eu la chance de tester la nouvelle version du référentiel Opquast à titre profess… perso… non, à titre professionnel (avec Opquast, je ne sais jamais si je le fais pour le boulot ou pour le plaisir !)

Bon, déjà, 217 bonnes pratiques à tester à la main (les tests automatiques n’étaient pas encore prêts), avec la bonne méthode (1), ben finalement, ça se fait.

Une fois que c’est fini, on a un résultat ; un pourcentage de conformité.

Ce qui me semble important – en dehors d’un état d’avancement et de marge de progression – c’est l’analyse que l’on peut en tirer.

En effet, plus que le résultat global, j’ai axé mon analyse sur :

- les résultats par niveau

- les résultats par « typologie » de critères

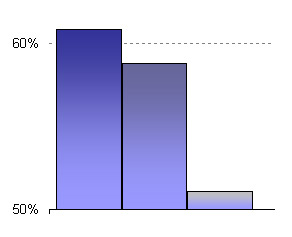

L’analyse par niveau

Constater que les résultats sont meilleurs sur les BP (Bonnes Pratiques) de niveau 1 démontre que les équipes web ont le bon esprit. Elles ne se perdent pas dans les détails et le peaufiné sans avoir traité les points importants en priorité.

Un taux de conformité globale à… disons 60% mais avec 30% de conformité en niveau 1 pour 80% de conformité en niveau 3 signifierait une mauvaises gestion des priorités et peut-être même une méconnaissance du média ! Rien que ça.

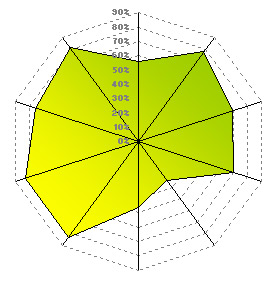

L’analyse par typologie de critères

Opquast a eu la bonne idée de classer les BP par groupes thématiques.

Avant d’analyser les résultats de mon audit, je me suis posé la question :

- des objectifs du site,

- et de la fréquence d’utilisation de certains éléments (ex. : tableaux, Flash) et de l’importance de l’information contenue

A l’aide de ces deux éléments, de manière naturelle, des typologies de critères se sont détachées comme étant plus stratégiques que d’autres.

Ce sont donc sur ces groupes que s’est focalisée mon attention.

En plus de l’analyse en détail, constater que la conformité globale des typologies stratégiques est plus élevée que celle des typologies mineures démontre encore que les équipes web suivent un axe logique par rapport à leurs buts.

Analyse en détail

Et bien sûr, une analyse d’un audit de qualité web n’est pas, certainement pas, une suite de pourcentages et de graphiques (aussi jolis soient-ils).

Une fois qu’on s’est focalisé sur un groupe de BP, on regarde en détail les points de non-conformité.

- Est-ce que ces points concernent tous une même étape (compétence, planning, outil) ?

- Est-ce qu’ils sont modifiables facilement ?

- Est-ce qu’ils font partie d’un choix stratégiques et n’ont pas à être modifiés ?

On se pose le même type de question sur les points de conformité et on se rend compte qu’on en tire rapidement des conclusions sur les axes forts et les axes faibles d’un site, d’une méthode, d’une équipe, etc.

À vos analyses !

(1) Il y a, si on veut, des formations pour ça chez ces messieurs de Temesis.

Il est à mon sens important de préciser que les bonnes pratiques sont un consensus. Que c’est ce qui ressort après réflexion, mais que l’on peut ne pas être d’accord sur certains points, vouloir aller plus ou moins loin sur certains points. Le principal étant de savoir pourquoi.

Et de se dire que si on est d’accord avec rien c’est qu’il doit y avoir un problème dans sa façon de voir 😉

Les bonnes pratiques (BP) ont, en effet, été préparées de façon collégiale. Une BP n’était acceptée que sous conditions (Opquast, L’Atelier > Onglet « Qu’entendez vous par « bonne pratique » dans le cadre de ce projet ? »).

Mais il est tout à fait possible de choisir de ne pas suivre une BP et d’assumer totalement ce choix. Cela peut être une décision ou une contrainte.

La liste des BP n’est, en effet, pas une « todo list » mais une grille d’évaluation.